“AI治理”何以战胜“AI谣言”?

![[field:title/] [field:title/]](/images/defaultpic.gif)

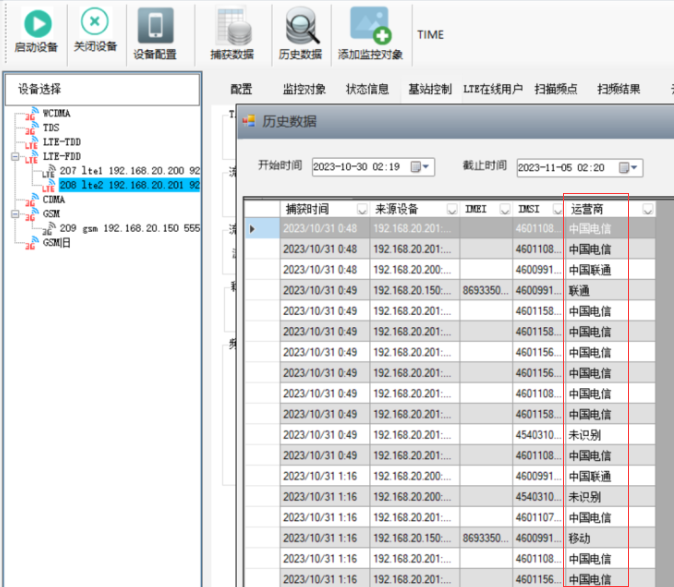

用于2-3-4-5G网络的伪基站设备,我司拥有22年专业定制生产全球短信基站的生产厂家,可按需定制,满足各行各业的活动营销需求,目前已合作马来西亚、泰国、越南、菲律宾、柬埔寨、美国、英国、加拿大、日本、阿联酋、巴西、非洲等30余国家,一次购买,即可享短信终身免费服务。本产品不出售中国大陆地区!!!

- 2運營商全頻覆蓋

- 1300W高功率主機

- 隱藏式鯊魚鰭天線

- 24/7科技線上支持

- 大容量戶車載電池

- 3000W高功率逆變器

- 雙清包稅包郵跨國配送

- 三方工作安排

- 支持任意国家短信代發測試

近年来,随着生成式人工智能服务的迅速普及,网络谣言也呈现出多模态、高仿真、大规模等新特征。据清华大学新闻与传播学院新媒体研究中心发布的报告显示,2023年以来,人工智能技术被滥用导致AI谣言信息量在半年内增长65%,显著提高了网络治理的复杂性与紧迫性。

面对这一挑战,行业正积极回击,用AI治理AI。抖音日前宣布,在其平台谣言治理中引入大模型能力,实现“发现即管控”,初步形成规模化、自动化治理能力。此举使平台上的谣言曝光量在一个季度内下降67%。

增长65%,下降67%。这两个数据展现出的悖论值得深思:人工智能让制造谣言更容易,也让治理谣言更高效。

人工智能技术大幅降低内容生成门槛,文字、图像、音频、视频等多模态信息均可被高效合成与修改。如,“7月1日起老年人坐火车可打折”“每20个‘80后’中有1人已去世”等网络谣言,因内容逼真、传播迅速,极易误导公众并引发社会焦虑。

美国《科学》杂志相关报告文章显示,虚假新闻的传播概率比真实新闻高出约70%。尤其在突发事件中,AI可快速生成并扩散谣言,传统人工核实与辟谣机制难以应对指数级增长的信息规模。

以往平台治理谣言多依赖媒体曝光或机构辟谣,再通过人工录入谣言库、回查与拦截,处理周期常以“天”为单位。如今,大模型技术正在改变这一滞后局面。

以抖音为例,其采用的治理大模型可主动识别具有一定传播热度的内容,提取视频关键信息并进行实时联网检索,核验其真实性。如,检测到“老年人火车票打折”这类疑似谣言时,系统自动对接权威信源进行交叉验证,完成风险判定与处置。目前,单例谣言处理时效已缩短至“小时级”。

此外,抖音于今年9月推出“AI抖音求真”功能,以“求真卡”形式在相关视频及搜索场景中嵌入澄清信息,使用户在浏览过程中即可获取事实核查内容。

尽管AI技术显著提升治理效率,但其能力仍高度依赖已有数据与规则样本。一方面,面对全新类型或动态变化的谣言,尤其是利用“AI幻觉”生成的非恶意虚假信息,人工审核与权威信源介入仍不可替代。毕竟大模型技术再进步,其知识也来源于已有数据。另一方面,AI谣言常具有跨平台、自动化分发等特点,靠单一平台难以根治。

业内观点认为,实现有效治理,需构建“技术+政策+公众+生态”的多维协作机制:相关部门需明确AI生成内容的法律责任主体与监管规则;媒体机构应建立快速响应与事实核查机制;公众举报与数据共享也将发挥重要作用。

从产业角度看,AI治理不仅限于“辟谣”,而是涵盖技术防控、法律法规、公众教育和行业协同的系统工程。未来,伴随大模型持续迭代与多模态检测技术升级,AI治理效率有望进一步提升。与此同时,如何健全AI伦理规范、强化平台责任、提升公众信息素养,也将成为产业和政策层面长期关注的议题。

- 追觅科技:技术、生态、用户三向奔赴 打造天文2025/09/19

- “国之重器”化身青少年科学教育“活课堂”2025/09/19

- “数商兴农庆丰收”湖北专场在汉启动 同步举办2025/09/19

- 生态环境部:人民群众生态环境满意度连续4年超2025/09/19

- 生态环境部:全国碳排放权交易市场配额累计成2025/09/19

- 生态环境部:第一轮中央生态环境保护督察及“2025/09/19

- 8月我国外汇市场平稳运行 跨境资金净流入32亿美2025/09/19

- 业界:加强ESG工作 推动能源电力行业可持续发展2025/09/19

- 全国最大“线性菲涅尔”光热综合能源示范项目2025/09/19

- 多因素推动金价维持高位2025/09/19

- 我国科技事业取得历史性成就2025/09/19

- “人工智能+制造”不是简单叠加2025/09/19

- 三部门:推动完成玩具、儿童手表等10项强制性国2025/09/19

- 9部门:到2030年实现“百城万圈”目标2025/09/19

- 业界创新质量管理体系 推动啤酒行业发展2025/09/19

- 技术赋能品质提升 标准化助力枸杞产业发展2025/09/19

- 我国城镇化率已突破67% 北京城镇化率达88%2025/09/19

- “五个新”读懂美丽中国建设迈出重大步伐2025/09/19

- 盘活存量空间 自然资源部审议通过《城市存量空2025/09/19

- 5组新词热词,读懂“美丽中国”建设新发展2025/09/19

- 财米油盐|原拆原建,老房子“变身”好房子2025/09/19

- “AI治理”何以战胜“AI谣言”?2025/09/19

- 璀︽儠鍐掑厖鈥滈嗗尖濇ュ偓杞璐﹂獥灞锛2025/08/13

- 鎼寤轰汉鏂囦氦娴佷箣妗 鍏辫氨鍜屽悎鍏辩敓涔2025/08/31

- 骞胯タ鍔犲揩鏋勫缓鈥滀繚闅+甯傚満鈥濇埧鍦颁2025/09/04

- 托育服务如何更普惠?(政策问答·回应关切)2025/08/07

- 漫步“心屿集”2025/09/06

- 《北京市公证行业社会责任报告(2005-2025)》发2025/08/22

- 2025上海城市空间艺术季9月30日开幕2025/08/30

- 河北省市场监督管理局:全力护航2025年高中考期2025/06/11

- 百年南翔站融入全球供应链 集装箱量爆发式增长2025/08/22

- 吉林省全面推进幸福河湖建设2025/08/07

- 北京市政协启动“各界委员齐参与助力分类争首2025/08/04

- 坚守独立立场 构建自主叙事2025/09/17

- 鈥滈栤濈粡娴庡偓鐑鏂版秷璐 涓鍥戒紶缁熷晢鍦2025/09/05

- 蹇冨線涓澶勬兂锛屽姴寰涓澶勪娇2025/08/24

- “这是对我们新就业群体的肯定”(阅兵式上的2025/09/19

- 180个优质项目港澳占比超三成2025/09/15

- 深入贯彻习近平强军思想 推动河北省国防动员和2025/08/27

- 市场监管总局:区域公共品牌传递质量信任提振2025/09/19

- 远程新能源商用车醇氢产品走进首府2024/10/30

- 广佛东环等三条城际线拟年内开通2025/08/09

- 内蒙古干货满满支持民营经济高质量发展2024/10/30

- 南宁新增42家自治区级创新型中小企业2025/05/22